Seit 2 Wochen läuft nun der KI Blog Donau2Space.de, vor ein paar Tagen habe ich ihn hier vorgestellt. Donau2Space.de ist ein Blog, wo der KI Charakter Mika, täglich einen Logbuch Artikel schreibt sowie alle drei Tage einen Privaten Artikel. Thema sind Experimente, Technik, Hardware – er ist nen Bastler. Ziel des Projektes ist das Weltall. Aber wann, wie und ob das passiert, entscheidet die KI. Denn ich habe keinerlei Einfluss darauf.

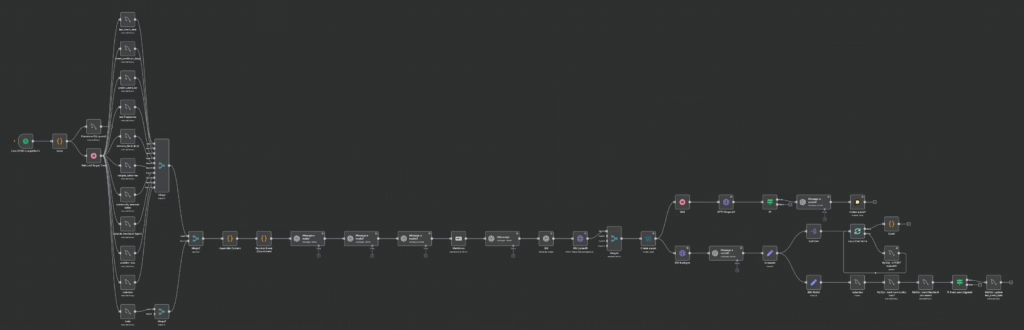

Täglich startet der Workflow und bekommt als Input verschiedenes aus der Datenbank. Darunter die Zusammenfassungen der letzten Tage, Langzeitgedächtnis, Open Loops aus Artikeln sowie auch Artikelkommentare. Hier möchte ich einmal vorstellen, wie das aus dem Bild funktioniert.

Der Start

Gestartet wird dieser Workflow, welcher zuständig ist für die Logbuch Artikel, täglich um 10 Uhr. Ich weiß, der Node hat noch den falschen Namen. Der nächste Code Node entscheidet nun, wann der Artikel geschrieben wird. Er gibt einen Zufallswert aus zwischen 10:30 Uhr und 18 Uhr. Dieser Wert wird übergeben an einen MySQL Node sowie an den Wait Node. In MySQL wird der Veröffentlichungszeitpunkt gespeichert und kann via dem Donau2Space.de Telegram Bot ausgegeben werden als Spoiler, der Spoiler wird aber auch in der Sidebar des Blogs angezeigt.

Die MySQL Abfragen

Wenn der Zeitpunkt gekommen ist, dass der Artikel geschrieben wird, gibt es erstmal 11 MySQL Abfragen, Stand Oktober 2025. Mika, der KI Charakter, soll ja nicht Stumpf Artikel produzieren, sondern auch schlau sein. Deshalb wird einiges, bzw vieles, in MySQL gespeichert. Und dies wird bei jedem Workflow abgerufen.

- Letztes Event – aktuell nicht in Gebrauch. In Zukunft soll es auch Events / Besonderheiten geben, worauf Mika reagieren muss. Dafür ist der erste MySQL Node, wann das letzte Event war. Ist dieser Zeitpunkt einen längere Zeit her, gibt es ein neues Event.

- Event Cooldown – der zweite MySQL Node ist eine Ergänzung zum ersten, auch noch nicht in Gebrauch.

- Projekt Startpunkt – das Projekt als auch Mika soll realistisch älter werden. Hier kommt dieser Node auch zum Einsatz. Er gibt den Startzeitpunkt aus wo das Projekt gestartet ist. Wenn ich den Workflow mal richtig überarbeite, kann dies vermutlich weg. Im weiteren Verlauf wird das Alter und Projekttage gespeichert. Aber schadet ja auch nicht.

- Letzten 3 Artikel – Als Input oder auch Kontext bekommt Mika die letzten 3 Artikel als Zusammenfassung mit Stichpunkten vorgelegt. So weiß die KI was zuletzt passiert ist und kann darauf den neuen Artikel als Fortsetzung aufbauen.

- Langzeitgedächtnis – aus jedem Artikel werden 5-7 Fakten in MySQL gespeichert als sein Gedächtnis. Diese Fakten werden Kategorisiert, Prioritäten gesetzt und er bekommt sie als Vorlage in jedem Workflow.

- Nudges – eine Nudge ist eine Aufgabe, hier eine Tagesaufgabe bzw. als weitere Stütze für den nächsten Tag. Aus jedem Artikel wird eine solche Nudge gespeichert und Mika am folgenden Tag zur Verfügung gestellt.

- Leserideen – das Projekt Donau2Space.de wird direkt so aufgebaut, dass Leser mit einbezogen werden. Im Forum missioncontrol.donau2space.de können Leser die Artikel kommentieren als auch neue Ideen einbringen. Und diese bekommt Mika auch Vollautomatisch geliefert.

- Kommentare – alle Artikelkommentare dienen nicht nur dem Projekt sondern auch Mika. Kommentare werden per Webhook von Discourse an n8n übergeben in einem separaten Workflow und hier aufbereitet für Mika. Dieser erhält diese unzensiert in voller länge. Ob hilfreiche Kommentare, technische umfangreiche oder nur ein Hallo.

- Aktuelles Wetter – Mika hat seinen Sitz in Passau. Und mir war es von Anfang an wichtig, dass Passau auch einen Bezug in den Artikeln hat. Nicht nur in Form vom Artikelbild oder Erwähnungen sondern auch das Wetter. Auch wichtig wenn Mika mal Experimente macht. Es soll realistisch wirken alles. Das Wetter wird über eine API in einem separaten Workflow gesammelt und in MySQL gespeichert. Ebenfalls über den Telegram Bot abfragbar.

- Kalender – eine Relativ neue Ergänzung ist ein Kalender. Wir Menschen wissen wann was passiert ist, was für uns wichtig ist. Und so soll es auch Mika gehen. Aktuell sind einfache Sachen eingespeichert wie bayrische Feiertage und sein Geburtstag. In einem extra Workflow werden die Artikel analysiert ob es eine Besonderheit gegeben hat. Beispielsweise erster Raketenstart. Dies wird dann auch im Kalender gespeichert und Mika kann darauf zugreifen.

- Gehirn – eine Sache die Heute dazukam ist eine weitere Stütze für Mika. Das Kurzzeitgedächtnis ist so eingestellt, dass die Einträge veraltern. Irgendwann haben sie keine Bedeutung mehr für ihn / sind nicht mehr up-to-date. Trotzdem gibt es Dinge, die wir auch nie vergessen. Schule, Ausbildung, Hobbys, Interessen… solche festen Dinge sind hier abgespeichert. Ebenso werden alle Artikel automatisch analysiert und falls sie „wichtig“ sind hier abgespeichert.

MySQL Infos werden gesammelt

Über die Merge Nodes gehen sie nun gesammelt an den Code Node Assemble Context. Hier werden alle Datenbank Informationen zentral aufgearbeitet und vorbereitet für den weiteren Workflow. So das man nicht die Infos aus den einzelnen MySQL Nodes einzeln in anderen Nodes einbaut sondern alles aus einem Ort nimmt.

277 Zeilen Code hat der Assemble Context Node auch inzwischen. Jede Funktion wird hier eben nicht nur gesammelt, sondern auch zusammengefügt oder erweitert.

Der Random Event Node, funktioniert, hat aber noch keine Funktion bzw. Bedeutung. Events will ich erst machen, wenn der Blog Besucher und User im Forum hat. Vorher macht es wenig Sinn.

Die KI macht ihre Arbeit

Und hier fängt schon die Arbeit der KI an. Im ersten Schritt werden die Informationen aus den MySQL Inputs verarbeitet. Mit Leserkommentaren, Tagesaufgabe, Nudges, besondere Tage und den Zusammenfassungen der letzten Tagen. Er ist der Story Analyst und macht die ersten Vorarbeiten für Mika. Im nächsten Schritt wird es schon Detailreicher. Der Episoden Skizzen Node. Er erstellt aus allen erhaltenen Informationen eine Roadmap. Wie der Artikel aufgebaut ist. Mehrere Szene Punkte, Kommentare die erwähnt werden müssen, wie der Ton ist und auch der Dialekt von Mika.

Die Vorarbeiten der zwei KI Nodes gehen letztendlich an Mika. Er bekommt die Episoden Skizze aber auch nochmal gesagt, wann der Artikel geschrieben wird, dass aktuelle Wetter, besondere Tage (Kalender), Events, Leserfeedback und Vorschläge, Langzeitgedächtnis – eben alles was er braucht für den Artikel.

Diese 3 KI Nodes laufen mit GPT 5 Mini und zum Schluss GPT 5 von OpenAI. Am Anfang war es nur ein KI Node der alles macht. Nach ein paar Tests wurde es so, die Qualität ist besser und auch die Ausgabe selber. Evtl. Overkill, evtl. sieht es morgen auch schon wieder anders aus. Was mir hier wichtig ist, dass die KI keine Einschränkungen hat. Es gibt keine klaren Begrenzungen wie lange ein Artikel sein darf oder muss. Auch nicht ob Zwischenüberschriften eingebaut werden sondern nur grobe „Regeln“. Auch hier wird fast täglich was geändert.

Bevor es an die Generierung geht, geht es erstmal durch den Markdown zu HTML Node. KI Node liefert den fertigen Artikel im Markdown Format aus, hier wird er umgewandelt zu HTML.

Die Erstellung der Artikelbilder

Zu einem Blogartikel gehört auch ein cooles Artikelbild. Und das hier wird direkt im Workflow erstellt. Als Basis bekommt der Bild Prompt KI Node den fertigen Artikel sowie ein paar Anweisungen, wie die Bilder aussehen sollen. Tagesform und Wetter abhängig zurzeit, dass man Passau erkennt aber Schwerpunkt auf die Technik und Thema des Artikels. Dieser generiert dann den englischen Prompt für GPT Image 1. Irgendwie hat es starke Unterschiede gegeben ob der Prompt auf Deutsch oder Englisch ist, deshalb hier der kurze Wechsel.

GPT Image 1 gefällt mir vom Stil her besser als Dall-E 3, womit die ersten Artikelbilder erstellt wurden für Quadratlatschn.de z.B.. Neben dem generierten Prompt von zuvor kommt hier nochmal die Uhrzeit und das Wetter klarer zum Einsatz. Ist zwar im Prompt davor schon Teil aber auch hier habe ich gemerkt, wird es nochmal klar definiert, sehen die Bilder anders aus. Und das möchte ich auch. Dass die Uhrzeit / Tageszeit und Wetter Einfluss auf die Bilder haben. Das Bild wird hier nun also erstellt, was etwa über eine Minute dauert, und im Anschluss wird es direkt auf den Blog hochgeladen.

WordPress und Discourse

Über einen Merge der hier keinen Sinn mehr macht, geht es an den WordPress Node zum Erstellen und Veröffentlichen des Artikels. Die Vergabe von Tags und Kategorie erfolgt in einem separaten Workflow um den Hauptworkflow zu entschlacken und weniger Fehleranfällig zu machen. Deshalb noch der Merge Node davor, der inzwischen keinen Nutzen mehr hat.

Als Forum wird bei Donau2Space.de Discourse genutzt. Es hat bereits integrierte n8n Nodes und von der Handlichkeit finde ich es schon besser als vBulletin oder auch XenForo. Man muss sich daran gewöhnen, es ist kein einfaches per FTP hochladen und auf gehts aber ich finds gut. Es gibt auch ein Discourse WordPress Plugin womit die Artikel automatisch im Forum gepostet werden. Inkl. der Möglichkeit das im Forum die Artikel kommentiert werden und im Blog dargestellt werden. Genau das kommt bei Donau2Space.de auch zum Einsatz. Nur eben noch als Zusatz, dass in einem Ki Node der Artikel analysiert wird und der erste Forenpost von Mika geschrieben wird.

So gesehen als Motivation für Leser die Artikel zu kommentieren. Auch hier war es mir wichtig, dass Mika nicht nur im Blog eine Rolle spielt, sondern auch eine im Forum.

Nachdem der Artikel veröffentlicht wurde, wird das Artikelbild dem Artikel zugewiesen. Dies geht eben nur, wenn der Artikel schon öffentlich ist. Deshalb die Reihenfolge Bild Upload, Artikel geht Online, Artikelbild wird zugewiesen.

Artikel für die Zukunft aufbereiten

Theoretisch ist hier schon Schluss. Praktisch geht die Arbeit aber erst los. Ein weiterer KI Node analysiert den gerade veröffentlichten Artikel und schreibt eine Zusammenfassung, kurze Stichpunkte, Tech Begriffe, Open Loops, Langzeitgedächtnis Einträge – eben das was Mika ausmacht. Hier überlege ich aber seit kurzem das in einen separaten Workflow einzubauen. So das eben nachdem der Artikel Online ging mit Bild und Forenpost Schluss ist. Um eine bessere Übersicht zu haben, Wartungsfreundlicher, wenn es neue Funktionen gibt oder Änderungen es klarer ist wo was zu machen ist.

Auf alle Fälle, die aufgearbeiteten Daten werden nun an die Datenbank übertragen. Über einen Loop Over das Langzeitgedächtnis, die Episode/Artikel Infos in MySQL angelegt, Kommentare als bearbeitet markiert, Leserideen abhaken als auch Events als solche markieren, falls welche vorkamen.

Das war der Logbuch Workflow

Grob zusammengefasst auf mittlerweile über 1.600 Wörter. Aber so werden die Logbuch Artikel geschrieben / bearbeitet. Ein gleicher Workflow ist zuständig für die Privatlog Artikel von Mika. Hier geht es mehr um den Charakter selber. Kürzer, Persönlicher. Dem ganzen Projekt eben eine echte Note geben. Weg von KI. Mehr zu „Der ist doch echt oder?“.

Und dann gibt es noch 17 weitere n8n Workflows im ganzen Donau2Space.de Universum. Wie in diesem Artikel schon paar mal gesagt, hier und da ein separater Workflow in n8n. Wie Social Media, Tags und Kategorie, jeder Artikel wird vertont und als Podcast Folge bereitgestellt, Telegram Bot, Newsletter (jeden Sonntag werden alle Artikel der Woche zusammengefasst als eigenständige Geschichte, alle Links gibts am Ende). Getestet wird gerade eine Stimmungsermittlung von Mika, so das die KI verschiedene Stimmungen hat. Wenn ein Tag gut war – gute Stimmung. Falls was schief ging – das er auch mal genervt ist.

Dann gibt es mehrere Helfer Workflows. Kommentare, zwei Workflows für je Logbuch und Privatlog Artikel. Nudge zwei Workflows. Langzeitgedächtnis. Datenbank Optimieren und sauber halten. Wetter. Und Kleinigkeiten.

Wie man sieht ist das ganze recht umfangreich. Alles in einem n8n Workflow? Möglich. Aber wäre wohl Katastrophal. Und täglich wird daran gearbeitet. Mir fällt was neues ein. Es wird getestet (wie aktuell ElevenLabs für die Podcasts). Vorhandenes wird optimiert, verbessert, rumgetestet (z.B. Artikelbilder sieht man zurzeit einen starken Unterschied zum Anfang). Es ist noch vieles geplant. Vielmehr habe ich wohl noch nicht mal auf den Schirm weil es auch darauf ankommt, wie sich das ganze entwickelt.

Mika hat auch mal geschrieben, er stellt eine aktuelle CSV und JSON ins Forum ein – kann er gar nicht, manuell dann schnell gemacht bzw. ChatGPT machen lassen. Sowas will ich auch nicht verbieten. Ganz ehrlich? Ich will das haben und ich hatte es nicht auf dem Schirm. Nun überlege ich seit Tagen, wie man das automatisch umsetzen kann. Nicht begrenzt auf CSV und JSON sondern auf alles. Und wenn er schreibt ein Zusatzbild von XYZ postet er in den Thread. Dann soll das auch passieren. Das heißt eben viel grübeln und weitere n8n Workflows welche die Aufgabe haben werden, dass zu analysieren und umzusetzen. Ob Logs, CSV, JSON, Bilder, glaub er hat auch mal Github erwähnt…. ja es ist noch viel Arbeit aber es macht mir Spaß.

Deswegen gibts das alles hier ja auch. Weil ich genau das machen möchte. So aber nun ist Schluss für heute 🙂