Anfang Dezember 2025 zuletzt hier gebloggt über Donau2Space, seitdem hat sich einiges getan. Wird also Zeit für ein Update. Aber erstmal den alten Artikel kurz überfliegen, was seitdem alles passiert ist…

Ah okay, mehr ein paar neue Funktionen aufgelistet. Also mach ich mal frei Schnauze.

git.Donau2Space.de

Mika hat relativ früh schon geschrieben, er stellt dieses und jenes ins git. Gabs nicht und will auch nicht, dass der KI Charakter was auf Github postet. Also erstmal über Umwege was gemacht, dass Zusatzinhalte ins Forum gepostet werden als Anhang. War eben meist 1-2 Phython Skripte als zip. Ne CSV und vielleicht eine json Datei. Das reichte mir aber nicht. Weil, keiner wird sich das downloaden und auf dem Computer anschauen, was da die KI geschrieben hat.

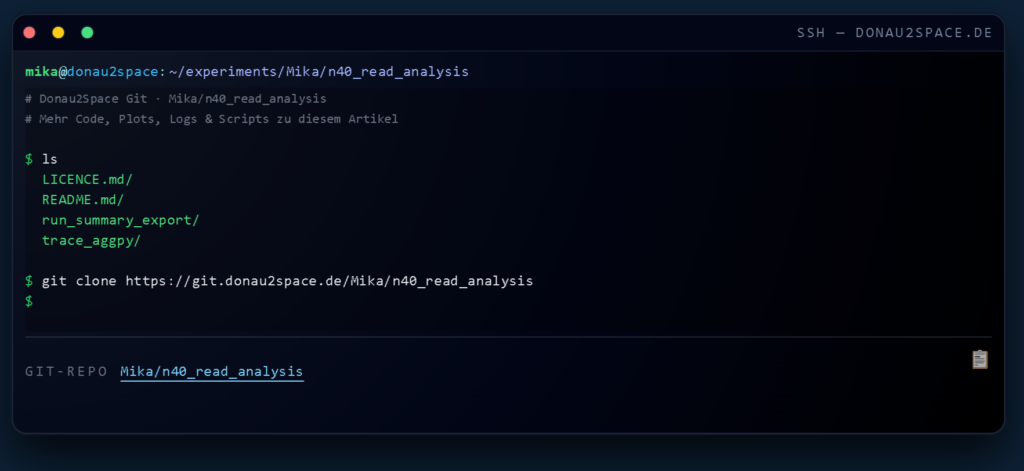

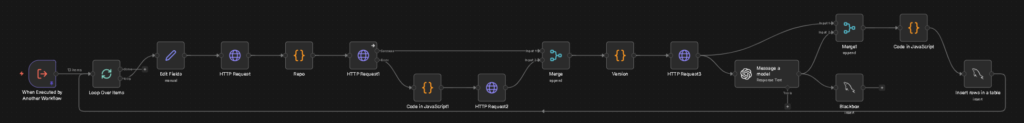

Also kam git.Donau2Space.de, hier kann man sich die jeweiligen Dateien direkt Online ansehen. Macht mehr aus und macht es auch „realer“. Von der Art her wie der Zusatzinhalte n8n Workflow, nur das dieser noch spezieller ist. Mehr KI Nodes besitzt. Und alles eben ins eigene git hochlädt, was auf Forgejo basiert.

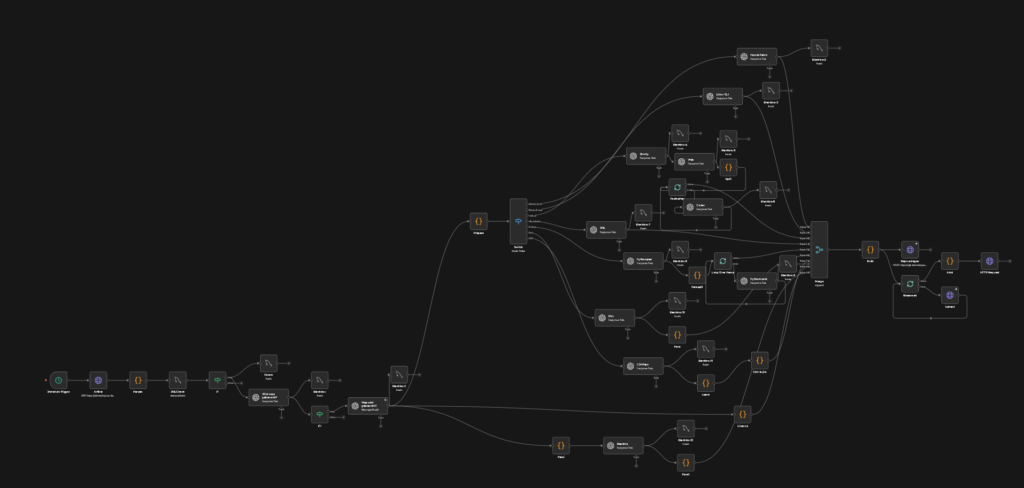

So sieht das am Ende aus. Das ganze läuft nun seit einem Monat in etwa und relativ täglich arbeite ich daran. KI Prompts optimieren, Output optimieren, auf das was Mika machen will reagieren. Das ganze wird aber langsam größer und auch „laggyer“. Plan für v2 steht, nach dem Switch Node im n8n Workflow das ganze an separate Workflows abgeben. So das man einen Linux Workflow hat, einen Python, einen SQL, einen Web, einen Readme und dann es gebündelt oder einzeln ins git hochgeladen wird.

Macht das ganze auch Wartungsfreundlicher und vor allem, die einzelnen Wege kann ich noch umfangreicher und komplexer machen – braucht man nicht aber für mich ist das immer noch ein Experiment mit KI und Automatisierung. Donau2Space im ganzen braucht man nicht – ich feier es aber.

Erstellte Inhalte welche ins git hochgeladen werden, werden dann wiederum so unter dem Artikel dargestellt. Vorher die Forenversion war mehr ne kleine Hinweisbox beim git habe ich ein wenig übertrieben. Vom Stil her wie ne Entwicklerkonsole – git eben, soll gut aussehen. Das Auge isst ja mit, wie man so schön sagt. Und es sieht verdammt gut und lecker aus, behaupte ich selber mal.

Der Podcast

Beim Podcast selber gab es nur leichte Anpassungen und Optimierungen, ich find den bisher ganz gut. Was neu ist, dass er bei mehr Verzeichnissen gelistet wird. Eben Spotify, Amazon Music, Audible, Apple Podcast, Podcast.de – neu ist dann Deezer und RTL+. Von den Aufrufzahlen hier, 70-100 Abspielungen am Tag. Zu 99% eben auch von / über diesen Verzeichnissen / Plattformen. Was mich natürlich persönlich auch freut, schade finde ich nur, man weiß eigentlich nicht, wo er gehört wird. Manche Plattformen bieten Statistiken, viele aber nicht. Auch denke ich, gibt es noch Zahlen im Schatten. Wo ein Anbieter die mp3 z.B. cached und vom eigenen Server abspielt. Diese Zahlen bekomm ich dann gar nicht mit. Was mich jetzt nicht schlecht schlafen lässt – interessiert mich eben.

interne Links

War auch ein Thema was mich lange beschäftigt hat, wie man am besten interne Links verbaut. Bloggt man selber, verbaut man hier und da nen Link. Auch gibt es WordPress Plugins, die für einen das machen. Man legt die Linkziele mit den Keywords an. Will ich aber nicht, es soll ja alles automatisiert sein bei diesem Projekt.

Mehrere Externe Anbieter angesehen, welche man mit dem eigenen WordPress verbindet, diese dann die Artikel per KI analysieren und interne Links vorschlagen und verbauen. Ein Anbieter, ich glaub von fünf getesteten, kam für mich in Frage – Preislich lagen wir aber bei rund 10$ im Monat dafür. Also einfach selber gebaut.

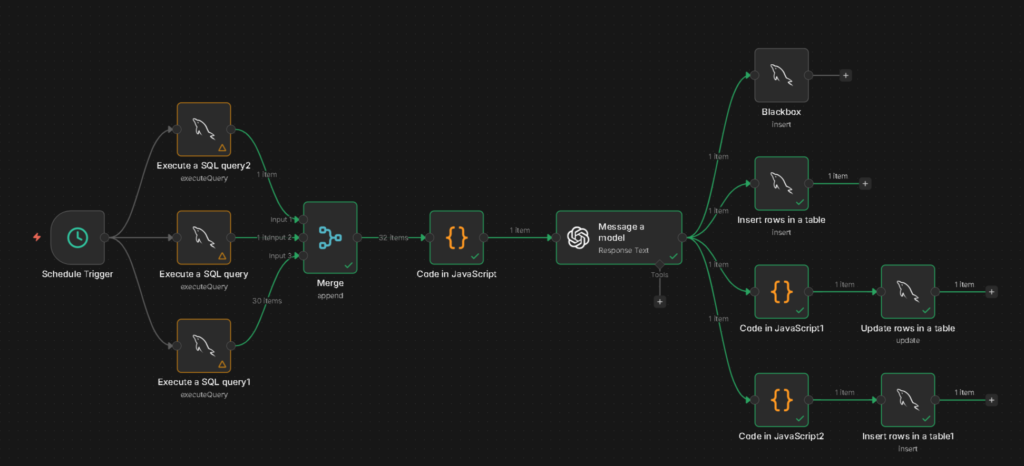

In der Datenbank setze ich manuell interne Links fest, bzw. mache dies über einen n8n Workflow, welcher den eingeschickten Artikel / Seite analysiert und eine kurze Zusammenfassung erstellt. Dies wird dann in der Datenbank gespeichert. Ein eigener n8n Workflow scannt die neuen Artikel und setzt themenrelevante interne Links ohne den Inhalt zu verändern.

Das ganze läuft erst seit wenigen Tagen, da bin ich noch am beobachten und „wie kann mans besser machen“.

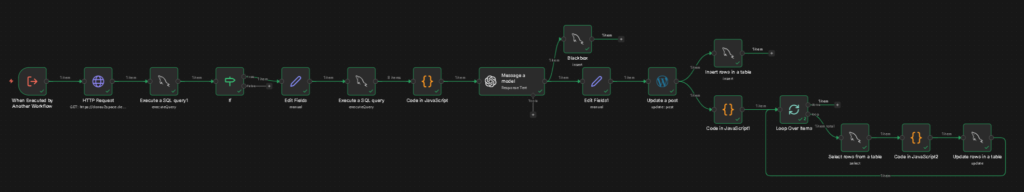

Das wäre dann eben der n8n Workflow, welcher die internen Links in den Artikeln verbaut. In der Datenbank werden gesetzte Links / wie oft verwendet gespeichert und ein kleines Scoring tritt in Kraft. Nicht das in jedem Artikel die selben Links gesetzt werden. Aktuell sind glaub ich rund 15 interne Links in der Datenbank gespeichert, so das die KI auch eine Auswahl hat was verlinkt werden kann.

Linux in der Beobachten

Unter anderem auch für die internen Links habe ich eine kleine neue Nerdseite aufgebaut. Linux in der Beobachtung. Da Mika ja auch über Kernel, Timestamps und co berichtet passte das ja perfekt. Einerseits eine kleine Informationsseite zum Thema Linux als auch – jede Seite ist in irgendeiner Form mit n8n und KI automatisiert, so auch hier – werden verschiedene Github und Gitlab Projekte im Artikel genannt. Dazu den letzten Commit, Sterne, Forks, Watcher – das man die ganze Seite ein wenig lebendiger macht.

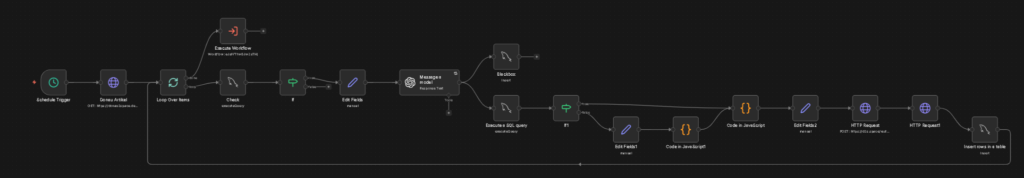

Das ist dann der n8n Workflow für Projekte die man auf Github vorfindet. In einer Datenbank werden die ganzen Projekte gespeichert und ein Auslöser Workflow triggert dann diesen Workflow, welcher dann die ganzen Github Projekte einzeln abarbeitet.

Mika soll mal über was neues schreiben

Auch an dem bin ich schon länger dran, dass er auch mal ein Thema fertig hat und was neues aufgreift. Dazu habe ich mehrere Versuche gemacht wie man es am besten machen kann. Von einem Hauptziel in ferner Zukunft mit verschiedenen Zwischenstopps und Episoden, alle per KI generiert, aufbereitet, analysiert, bearbeitet… bis hin zum aktuellen Versuch den Nudge „größer“ zu machen.

Kommt ein neuer Artikel wird dieser kurz von der KI analysiert und ein Nudge / Tagesaufgabe für morgen generiert. Das ganze ist nun dezent größer und umfangreicher geworden, dass Mika kein festes Hauptziel hat in ferner Zukunft, sondern die KI selber weiter entscheiden kann wie und mit was es weitergeht nur mit dem Unterschied, dass ein Thema auch mal genug ist – wenn es der Fall ist. Denn es gibt kein Zeitrahmen wann wie was fertig sein muss.

Das ganze sieht dann so aus in n8n – sry das die Nodes nicht betitelt sind. Das ganze wie man es hier sieht läuft nun seit etwa einer Woche und bisher bin ich mit dem Output daraus zufrieden. Nun heißt es eben abwarten, ob es auch zum gewünschten Themenwechsel mal kommen wird. Dazu sind auch die KI Nodes im Hauptworkflow optimiert – auf einen Themenfortschritt.

Wie man sieht, viele Baustellen

Und das ist seit Anfang an so und wird sich vermutlich auch nicht ändern. Wobei ich nun schon an einem Punkt bin und nicht 5 neue Sachen gleichzeitig aufziehe, sondern lieber nur 3 und 2 am optimieren. Oder besser gesagt, weniger komplett neues als vorhandenes optimieren. Das Grundgerüst stärken (z.B. interne Links). Als auch weiter Tests machen. So habe ich mal den ganzen Workflow umgebaut, dass nicht mehr OpenAI die Artikel schreibt sondern Grok. Preislich wäre Grok glaube ich sogar günstiger, der Output ist auch anders / OpenAI ist mehr konservativer als Grok – so habe ich das Gefühl aber für mich noch kein Grund zum kompletten Wechsel.

Preislich komplett würde ich gerne auch ein Update geben, kann ich aber nicht. Oder ich schau mal kurz ins OpenAI Dashboard, letzter Preis pro Artikel mit allem drum und dran lag ja bei 1,21 Euro, soweit ich mich erinnern kann. Nun… da sind wir drüber. Vereinzelt auf einen Artikel lässt es sich schwer sagen, da viele KI Arbeiten drum herum auch sind. Also nicht nur Sachen wie die Linux Seite wo Github und Gitlab Projekte alle 12 Stunden von der KI bearbeitet werden / Commits übersetzt, sondern auch das eigene git oder der neue Nudge.

Ich würde jetzt mal behaupten, 1,50 Euro pro Artikel – also rein ein Artikel mit Text, Bild, Diagramme, git, Podcast.

Ha! Was neues fast vergessen, was mehr Spielerei ist und jetzt passend ist um sich von den Kosten abzulenken…

d2s.space

Die Donau2Space Artikeltitel sind ja relativ gesehen lange. z.B. von gestern: Tag 124 — 13:03: Klarer Himmel über Passau, und ich friere mein N40-Run-Set wirklich ein. Macht auch direkt die URL länger, in dem Fall https://donau2space.de/tag-124-1303-klarer-himmel-ueber-passau-und-ich-friere-mein-n40-run-set-wirklich-ein/. Postet man das ganze bei Social Media, kürzen die meisten Netzwerke den Link schon und es steht dann sowas da wie https://donau2space.de/tag-124-1303-…. – sieht kacke aus. Also einen URL Shortener. Aber nen fertigen wollt ich nicht oder besser gesagt, ich wollte keine Massenware. Auch hier wollte ich die Kontrolle selber haben und das ganze auch automatisieren.

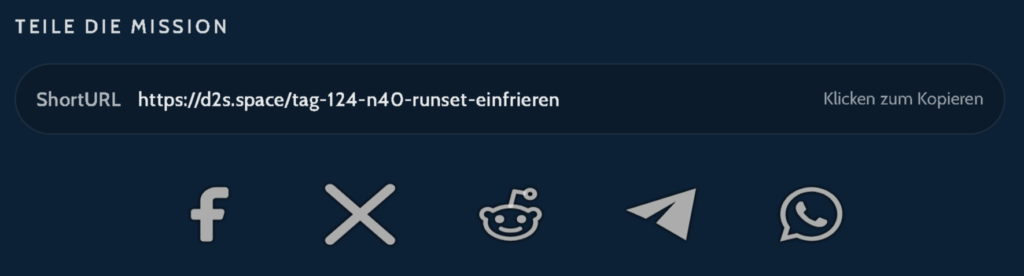

Ne kurze Domain mit .de Endungen, findest keine gute mehr. Also überlegt, was gibts denn so alles an neuen Endungen. Da kam mir .space ins Auge und d2s war hier auch noch frei. Und schwup di wups wird aus der langen URL von oben das hier: https://d2s.space/tag-124-n40-runset-einfrieren

Und so sieht bei mir der n8n Workflow dafür aus. Als Open Source Software wird Shlink genutzt auf d2s.space und die Links werden passend gekürzt mit Hilfe von KI. Im Grunde ist der Ablauf so: neuer Artikel wird gescannt aber nur der Titel. Basierend rein auf dem Titel wird eine kurz Version vorgeschlagen. Bei Logbuch Artikel welche den Tag 124 beinhalten, kommt dieser mit rein. Bei Experimenten oder Privatlog Artikeln nicht. KI schlägt also eine Kurzversion vor, anschließend wird geschaut, gibt es die Kurzversion schon – wenn ja, kommt ein Zusatz am Ende hinzu.

Bei Logbuch – täglichen technischen Artikeln – sehe ich da weniger ein Problem. Bei Experimenten / Privatlog Artikeln könnte es hingegen schon passieren, dass eine Kurzfassung wiederholt werden könnte – deshalb hier der Check und bevor man nochmal die KI nach einer neuen Fassung fragt eben etwas generisches dahinter.

Shortlink wird dann als Post Meta Wert in dem Artikel gespeichert, dieser wird dann auch unter dem Artikel angezeigt als auch beim Social Media Workflow dann verwendet für X, Facebook und Instagram. Dafür ist d2s.space ja eigentlich da.

Braucht mans? Nein. Der Kosten Nutzen Faktor ist gleich 0. Es gibt deswegen nicht mehr Zeichen bei X, vielleicht 1-2. Aber es sieht halt eben „hübscher“ aus finde ich. Und wie gesagt, vieles oder besser gesagt, alles hier ist ein Experiment. Ich schau mir unzählige APIs an und überlege mir, was könnte ich damit machen?

Spotify ist als nächstes dran, wenn man wieder ne Webapp erstellen kann. Aber keine Sorge, nicht für KI generierte Songs 😉

Das solls gewesen sein als erstes Update in diesem Jahr. Man sieht, es passiert weiterhin viel und alles bleibt weiter komplett übertrieben.